英伟达 NVIDIA GH200 超级服务器

英伟达 NVIDIA GH200 超级服务器

英伟达 NVIDIA GH200 超级服务器

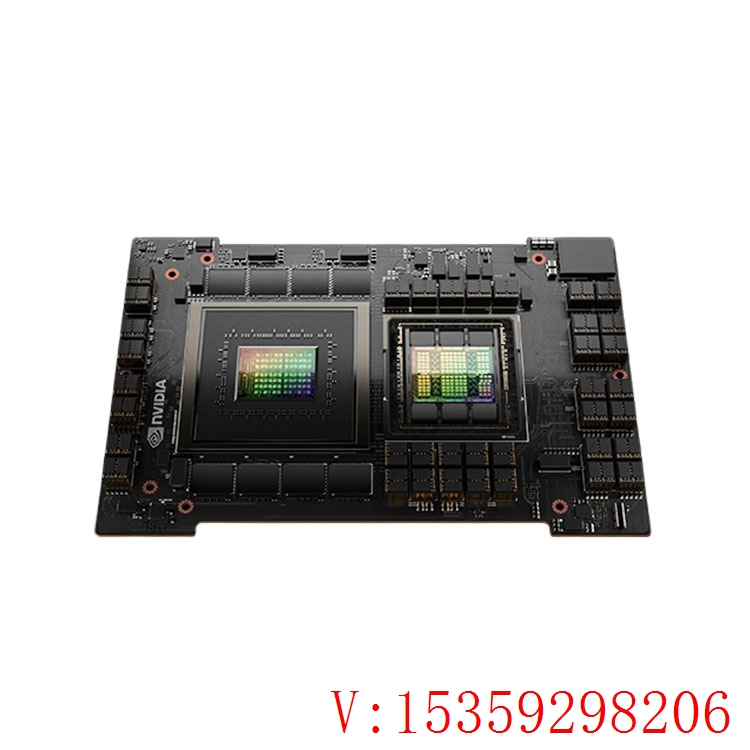

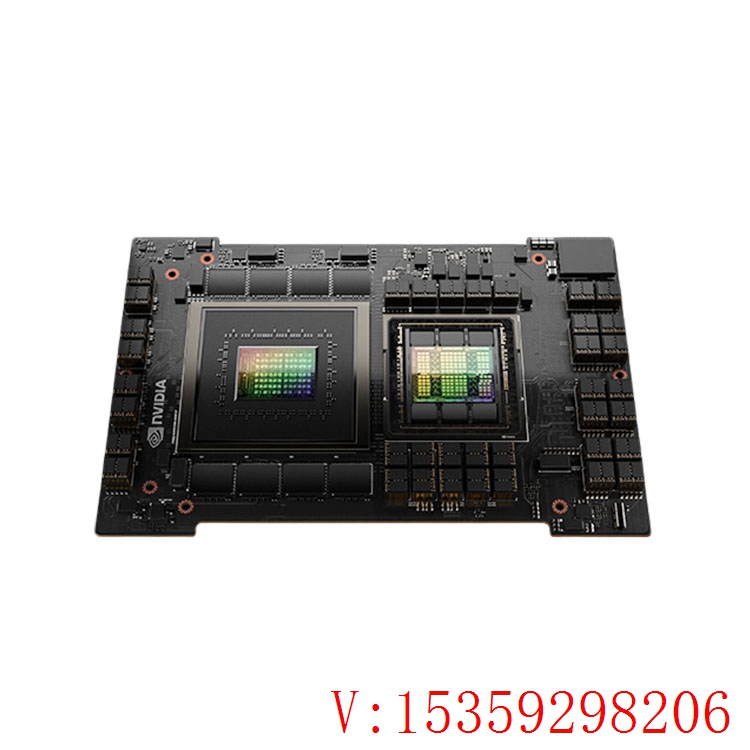

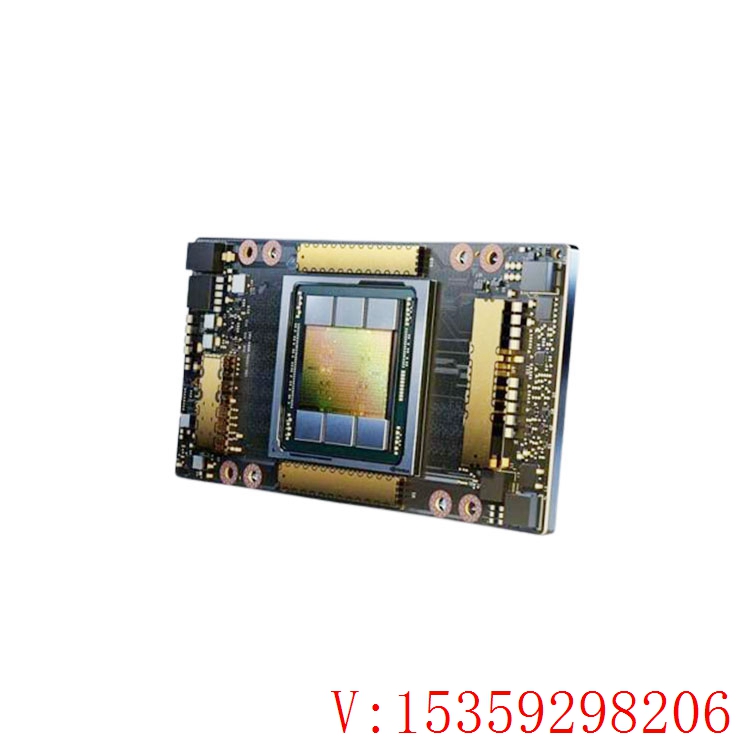

GH200超级芯片:整合了Grace CPU和H100 GPU,具有2000亿个晶体管

GH200超级芯片运用NVIDIA NVLink-C2C芯片互连,将根据Arm的NVIDIA Grace CPU与NVIDIA H100 Tensor Core GPU整合在了一起,以供应CPU+GPU一致性内存模型,从而不再需求传统的CPU至GPU PCIe联接。与新的PCIe Gen5技术比较,这也将GPU和CPU之间的带宽行进了7倍,将互连功耗减少了5倍以上,并为DGX GH200超级核算机供应了一个600GB的Hopper架构GPU构建模块。

详细来说, GH200超级芯片,是将 72 核的Grace CPU、H100 GPU、96GB 的 HBM3 和 512 GB 的 LPDDR5X 集成在同一个封装中,具有高达 2000 亿个晶体管。这种组合供应了 CPU 和 GPU 之间惊人的数据带宽,高达 900G / s,为某些内存受限的作业负载供应了巨大的优势。

黄仁勋标明,GH200 Grace Hopper超级芯片已全面投产,将可为作业杂乱的AI和高功用核算作业负载供应动力。

NVIDIA DGX GH200:AI功用打破1 Exaflop

NVIDIA此前的 DGX A100 体系只能将八个 A100 GPU 联合起来作为一个单元,面对生成式人工智能大模型关于算力的爆炸式增加,NVIDIA的客户迫切需求更大、更强壮的体系。DGX GH200便是为了供应大的吞吐量和可扩展性而规划的。

DGX GH200通过定制的NVLink Switch System(包含 36 个 NVLink 开关)将256个GH200超级芯片和高达144TB的同享内存联接成一个单元,防止规范集群联接选项(如 InfiniBand 和以太网)的约束,这种新的互连方法使DGX GH200体系中的256个H100 GPU作为一个整体协同作业,使其成为了专为高端的人工智能和高功用核算作业负载而规划的体系和参阅架构。可支持数万亿参数AI大模型练习。

△DGX GH200比较上代DGX A100的同享内存容量提高了近500倍。

在 DGX GH200 体系中,GPU 线程能够运用 NVLink 页表寻址来自 NVLink 网络中其他 Grace Hopper 超级芯片的对等 HBM3 和 LPDDR5X 内存。NVIDIA Magnum I/O加速库优化 GPU 通讯以行进功率,增强全部 256 个 GPU 的应用程序扩展。

△包含 256 个 GPU 的 NVIDIA DGX GH200与NVLink体系的拓扑结构

DGX GH200体系中的每个Grace Hopper Superchip 都与一个NVIDIA ConnectX-7网络适配器和一个NVIDIA BlueField-3 NIC配对。DGX GH200 具有 128 TBps 对分带宽和 230.4 TFLOPS 的 NVIDIA SHARP 网内核算,可加速 AI 中常用的团体操作,并通过减少团体操作的通讯开销,将 NVLink 网络体系的有用带宽行进一倍。ConnectX-7 适配器还能够互连多个DGX GH200 体系,以扩展到跨越256个GPU的更大的解决方案。

黄仁勋标明,DGX GH200 是“巨型 GPU”,这也是NVIDIA次运用 NVLink Switch 拓扑结构来构建整个超级核算机集群,这种结构供应了比前一代体系高出10倍的GPU到GPU带宽,以及7倍的CPU到GPU的带宽。它还规划了供应比竞争对手高出 5 倍的互连功耗功率和高达 128 TB / s 的对分带宽。该体系有 150 英里(约 241.4公里)的光纤,并且重达 4 万磅(约18.14吨),可是呈现出来就像一个单一的 GPU。

详细功用方面,得益于DGX GH200高达144TB的同享内存,使得其关于受 GPU内存大小瓶颈影响的AI和HPC应用程序的功用有了极大的提高。例如具有 TB 级嵌入式表的深度学习引荐模型 (DLRM)、TB 级图形神经网络练习模型或大型数据剖析作业负载中,运用 DGX GH200 可完成 4 至 7 倍的加速。这标明 DGX GH200 是更的 AI 和 HPC 模型的更好解决方案,这些模型需求海量内存来进行 GPU 同享内存编程。

H100 GPU服务器

Supermicro(超微) 提供超过20种组合式解决方案,可让客户从支持全新 NVIDIA H100 GPU 的 8U、5U、4U、2U 和 1U 系统中选择,將 AI/ML、高性能计算(HPC)和推论工作负载化。

通过 NVIDIA H100 PCIe GPU 认证的 Supermicro 系统配备 NVIDIA AI Enterprise,这套端对端云端原生AI及资料分析套装软件经过优化,可供企业使用AI。配备NVIDIA AI Enterprise 的 Supermicro 系统结合 NVIDIA H100 GPU,可简化AI就绪平台的构建,加速AI开发及部署,并提供性能、安全性及可扩展性,从而以更快的洞察力快速实现商业价值。

Supermicro(超微) 针对 NVIDIA H100 GPU 将特定当前一代系统进行认证,目前可提供 Supermicro GPU 服务器 SYS-420GP-TNR、SYS-420GP-TNR2 以及SYS-740GP-TNRTSupermicro 工作站等。通过对当前出货的工作站提供 NVIDIA H100 GPU 认证,客户可保留现有的 CPU 选择,同時享有全新 GPU 帶來的性能提升。此外,配合抢先体验计划,搭载 NVIDIA H100 GPU 的新一代 Supermicro(超微) 系统已开始出货。

其他相关型号

| N卡 N服务器到货计划 |

| A800 PCIE 单卡 |

| A800 NVLink 8卡模组 |

| A100 超微NV服务器 |

| A100 PCIE 单卡 |

| H800 超微NV服务器 |

| H100 PCIE 单卡 |

| H100 超微NV服务器 |

| GH200 超级服务器 |

客服1

客服1