A100 PCIE 单卡 Aurora超级计算机

A100 PCIE 单卡 Aurora超级计算机

A800参数

写在前面,现在是2023年3月21。美国禁令的影响下,A100 80G PCIE都很难在市场上买到,属于理财型GPU。

2月份还有知友问过我,那个时候H100都能找到货.....至于SXM版的去年就找不到了。

-----------------------------------------------------------------------------------------

关键参数搭载 2 个 GPU 的 NVIDIA® NVLink® 桥接 器 :600GB/s** PCIe 4.0 :64GB/s

被阉割了200GB/s

其余基本一致

目前我接触的能出的方案:

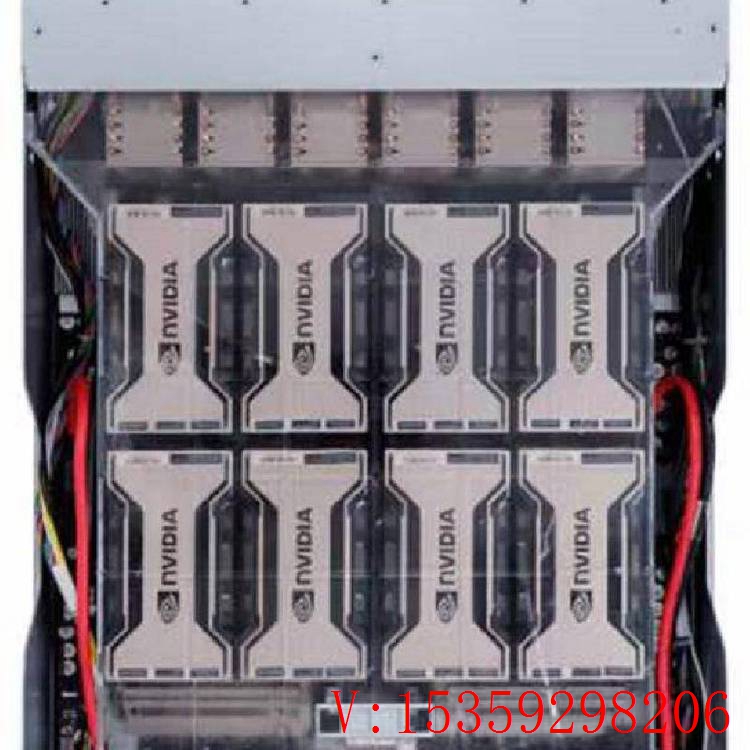

1.超微420GP-TNAR+8卡SXM A100 80G

根据目前询价的迹象,超微可能不出A100 SXM了,截止11月4号前还能询到价格

MLPerf 0.7 RNN-T measured with (1/7) MIG slices. Framework: TensorRT 7.2, dataset = LibriSpeech, precision = FP16。

高功用核算

为了获得新一代的发现效果,科学家们希望通过仿真来更好地了解我们周围的国际。

NVIDIA A100 选用双精度 Tensor Core,完结了自 GPU 推出以来高功用核算功用的巨大腾跃。结合 80GB 的超快 GPU 显存,研究人员可以在 A100 大将 10 小时双精度仿真缩短到 4 小时以内。HPC 运用还可以运用 TF32 将单精度、布满矩阵乘法运算的吞吐量前进高达 10 倍。

关于具有超大数据集的高功用核算运用,显存容量添加的 A100 80GB 可在工作材料仿真 Quantum Espresso 时将吞吐量前进高达 2 倍。极大的显存容量和超快速的显存带宽使 A100 80GB 十分适宜用作新一代作业负载的途径。

四年来 HPC 功用前进 11 倍

抢手 HPC 运用

运用加速的几何平均值与 P100 加速功用对比:基准运用:Amber [PME-Cellulose_NVE]、Chroma [szscl21_24_128]、GROMACS [ADH Dodec]、MILC [Apex Medium]、NAMD [stmv_nve_cuda]、PyTorch (BERT-Large Fine Tuner]、Quantum Espresso [AUSURF112-jR]、随机森林 FP32 [make_blobs (160000 x 64 : 10)]、TensorFlow [ResNet-50]、VASP 6 [Si Huge] | 包含双路 CPU 和 4 块 NVIDIA P100、V100 或 A100 GPU 的 GPU 节点。

HPC 运用的功用前进高达 1.8 倍

Quantum Espresso

大数据分析基准检验 | 针对 10TB 数据集的 30 次分析零售查询、ETL、ML、NLP | V100 32GB,RAPIDS/Dask | A100 40GB 和 A100 80GB,RAPIDS/Dask/BlazingSQL

数据科学家需求可以分析和可视化巨大的数据集,并将其转化为贵重见地。可是,因为数据集分散在多台服务器上,横向扩展解决方案往往会陷入困境。

搭载 A100 的加速服务器可以供应必要的核算才能,并能运用大容量显存、逾越 2 TB/s 的显存带宽以及通过 NVIDIA® NVLink® 和 NVSwitch™ 完结的可扩展性,处理这些作业负载。通过结合 InfiniBand、NVIDIA Magnum IO™ 和 RAPIDS™ 开源库套件(包含用于履行 GPU 加速的数据分析的 RAPIDS Accelerator for Apache Spark),NVIDIA 数据中心途径可以加速这些大型作业负载,并完结超高的功用和功率水平。

在大数据分析基准检验中,A100 80GB 供应的见地吞吐量比 A100 40GB 高两倍,因此十分适宜处理数据集大小急增的新式作业负载。

为企业前进资源运用率

凭仗多实例 GPU (MIG),推理吞吐量可前进高达 7 倍

BERT Large 推理

BERT Large 推理 | 选用稀疏技术的 NVIDIA TensorRT™ (TRT) 7.1 | NVIDIA T4 Tensor Core GPU: TRT 7.1, precision = INT8, batch size = 256 | V100: TRT 7.1, precision = FP16, batch size = 256 | A100 with 1 or 7 MIG instances of 1g.5gb: batch size = 94, precision = INT8。

A100 结合 MIG 技术可以更大限度地前进 GPU 加速的根底设备的运用率。凭仗 MIG,A100 GPU 可划分为多达 7 个独立实例,让多个用户都能运用 GPU 加速功用。凭仗 A100 40GB,每个 MIG 实例可分配多达 5GB,而随着 A100 80GB 显存容量的添加,此大小可翻倍至 10GB。

MIG 与 Kubernetes、容器和根据服务器虚拟化途径的服务器虚拟化合作运用。MIG 可让根底设备管理者为每项作业供应大小适宜的 GPU,一同保证服务质量 (QoS),然后扩展加速核算资源的影响规划,以掩盖每位用户

2.技嘉好像能出准系统+8卡SXM A100 80G,想了解的同学可以私信聊一下

3.超微420GP-TNR+8卡PCIE A100 80G+NvLink Brige Slot * 12(应该是每两张卡用3个,8张卡用12个)

这个方案性能估计是不如SXM协议的,不然也不会出A100 SXM了。

至于提到的A800,虽然看着是小砍一刀,但是整体通信带宽性能砍了33%。在还能上A100 SXM之前,有条件的同学可以抓紧时间了。

--------------------------------------------------------------分割线

如今A100已经不推荐了,禁售情况下,保修是个难题,何况市面上A100 80G 基本是拆机。

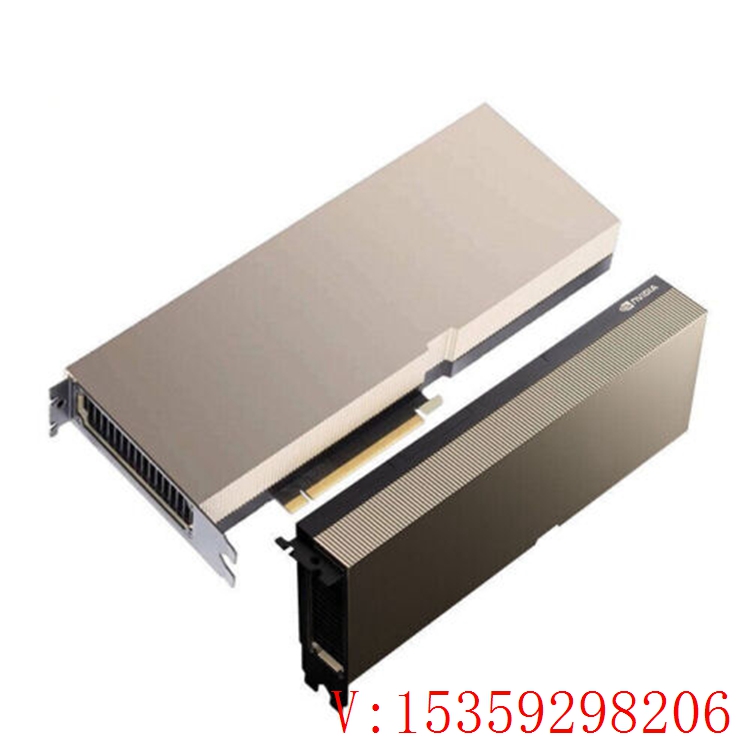

| A800 PCIE 单卡 | 330片,现货 |

| A800 NVLink 8卡模组 | 180片,现货 |

| A100 超微NV服务器 | 50台,现货 |

| A100 PCIE 单卡 | 150片,现货 |

| H800 超微NV服务器 | 30台,下周 |

| H100 PCIE 单卡 | 119片,下周 |

| H100 超微NV服务器 | 20台,现货 |

| GH200 超级服务器 | 24台,下周 |

客服1

客服1