A800 PCIE 单卡 半导体单卡 AI人工智能工业化

A800 PCIE 单卡 半导体单卡 AI人工智能工业化

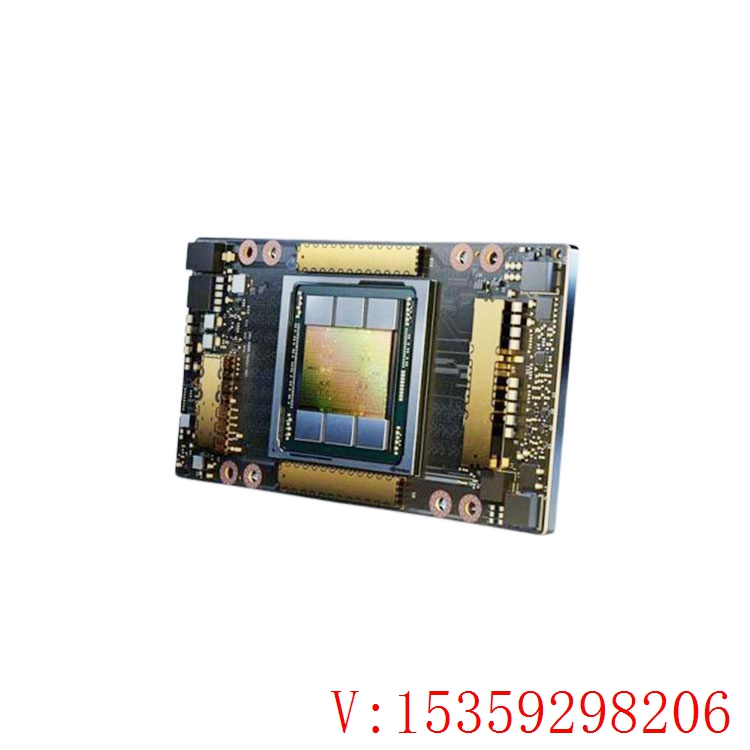

NVIDIA A100 Tensor Core GPU 可针对 AI、数据分析和 HPC 运用场景,在不同规划下完结超卓的加速,有效助力更高功用的弹性数据中心。A100 选用 NVIDIA Ampere 架构,是 NVIDIA 数据中心途径的引擎。A100 的功用比上一代产品前进高达 20 倍,并可划分为七个 GPU 实例,以根据改动的需求进行动态调整。A100 供应 40GB 和 80GB 显存两种版别,A100 80GB 将 GPU 显存添加了一倍,并供应超快速的显存带宽(每秒逾越 2 万亿字节 [TB/s]),可处理超大型模型和数据集。

功用强大的端到端 AI 和 HPC 数据中心途径

A100 是整个 NVIDIA 数据中心解决方案的一部分,该解决方案由硬件、网络、软件、库以及 NGC™ 中经优化的 AI 模型和运用等叠加而成。它为数据中心供应了强大的端到端 AI 和 HPC 途径,让研究人员可以快速交付真实的效果,而且大规划地将解决方案布置到出产环境中。

深度学习操练

针对大型模型供应高达 3 倍的 AI 操练速度

DLRM 操练

DLRM on HugeCTR framework, precision = FP16 | NVIDIA A100 80GB batch size = 48 | NVIDIA A100 40GB batch size = 32 | NVIDIA V100 32GB batch size = 32.

当今的 AI 模型面临着对话式 AI 等更高层次的应战,这促使其凌乱度呈爆破式添加。操练这些模型需求大规划的核算才能和可扩展性。

NVIDIA A100 Tensor Core 凭仗 Tensor 浮点运算 (TF32) 精度,可供应比 NVIDIA Volta 高 20 倍之多的功用,而且无需更改代码;若运用自动混合精度和 FP16,功用可进一步前进 2 倍。与 NVIDIA® NVLink®、NVIDIA NVSwitch™、PCIe 4.0、NVIDIA® InfiniBand® 和 NVIDIA Magnum IO™ SDK 结合运用时,它能扩展到数千个 A100 GPU。

2048 个 A100 GPU 可在一分钟内成规划地处理 BERT 之类的操练作业负载,这是十分快速的解决问题速度。

关于具有巨大数据表的超大型模型(例如深度学习引荐模型 [DLRM]),A100 80GB 可为每个节点供应高达 1.3TB 的一致显存,而且吞吐量比 A100 40GB 多高达 3 倍。

NVIDIA 的地位在 MLPerf 这个行业级 AI 操练基准检验中得到印证,创下多项功用纪录。

深度学习推理

A100 引入了突破性的功用来优化推理作业负载。它能在从 FP32 到 INT4 的整个精度规划内进行加速。多实例 GPU (MIG) 技术答应多个网络一同根据单个 A100 工作,然后优化核算资源的运用率。在 A100 其他推理功用增益的根底之上,仅结构稀疏支撑一项就能带来高达两倍的功用前进。

在 BERT 等先进的对话式 AI 模型上,A100 可将推理吞吐量前进到高达 CPU 的 249 倍。

在遭到批量大小限制的极凌乱模型(例如用于自动语音辨认用处的 RNN-T)上,显存容量有所添加的 A100 80GB 能使每个 MIG 的大小添加一倍,并供应比 A100 40GB 高 1.25 倍的吞吐量。

NVIDIA 产品的超卓功用在 MLPerf 推理检验中得到验证。A100 再将功用前进了 20 倍,进一步扩展了这种功用优势。

与 CPU 比较,AI 推理功用前进

高达 249 倍

BERT-LARGE 推理

BERT-Large Inference | CPU only: Xeon Gold 6240 @ 2.60 GHz, precision = FP32, batch size = 128 | V100:选用稀疏技术的 NVIDIA TensorRT™ (TRT) 7.2, precision = INT8, batch size = 256 | A100 40GB and 80GB, batch size = 256, precision = INT8。

与 A100 40GB 比较,AI 推理功用前进

1.25 倍

MLPerf 0.7 RNN-T measured with (1/7) MIG slices. Framework: TensorRT 7.2, dataset = LibriSpeech, precision = FP16。

高功用核算

为了获得新一代的发现效果,科学家们希望通过仿真来更好地了解我们周围的国际。

NVIDIA A100 选用双精度 Tensor Core,完结了自 GPU 推出以来高功用核算功用的巨大腾跃。结合 80GB 的超快 GPU 显存,研究人员可以在 A100 大将 10 小时双精度仿真缩短到 4 小时以内。HPC 运用还可以运用 TF32 将单精度、布满矩阵乘法运算的吞吐量前进高达 10 倍。

关于具有超大数据集的高功用核算运用,显存容量添加的 A100 80GB 可在工作材料仿真 Quantum Espresso 时将吞吐量前进高达 2 倍。极大的显存容量和超快速的显存带宽使 A100 80GB 十分适宜用作新一代作业负载的途径。

四年来 HPC 功用前进 11 倍

抢手 HPC 运用

运用加速的几何平均值与 P100 加速功用对比:基准运用:Amber [PME-Cellulose_NVE]、Chroma [szscl21_24_128]、GROMACS [ADH Dodec]、MILC [Apex Medium]、NAMD [stmv_nve_cuda]、PyTorch (BERT-Large Fine Tuner]、Quantum Espresso [AUSURF112-jR]、随机森林 FP32 [make_blobs (160000 x 64 : 10)]、TensorFlow [ResNet-50]、VASP 6 [Si Huge] | 包含双路 CPU 和 4 块 NVIDIA P100、V100 或 A100 GPU 的 GPU 节点。

HPC 运用的功用前进高达 1.8 倍

Quantum Espresso

大数据分析基准检验 | 针对 10TB 数据集的 30 次分析零售查询、ETL、ML、NLP | V100 32GB,RAPIDS/Dask | A100 40GB 和 A100 80GB,RAPIDS/Dask/BlazingSQL

数据科学家需求可以分析和可视化巨大的数据集,并将其转化为贵重见地。可是,因为数据集分散在多台服务器上,横向扩展解决方案往往会陷入困境。

搭载 A100 的加速服务器可以供应必要的核算才能,并能运用大容量显存、逾越 2 TB/s 的显存带宽以及通过 NVIDIA® NVLink® 和 NVSwitch™ 完结的可扩展性,处理这些作业负载。通过结合 InfiniBand、NVIDIA Magnum IO™ 和 RAPIDS™ 开源库套件(包含用于履行 GPU 加速的数据分析的 RAPIDS Accelerator for Apache Spark),NVIDIA 数据中心途径可以加速这些大型作业负载,并完结超高的功用和功率水平。

在大数据分析基准检验中,A100 80GB 供应的见地吞吐量比 A100 40GB 高两倍,因此十分适宜处理数据集大小急增的新式作业负载。

为企业前进资源运用率

凭仗多实例 GPU (MIG),推理吞吐量可前进高达 7 倍

BERT Large 推理

BERT Large 推理 | 选用稀疏技术的 NVIDIA TensorRT™ (TRT) 7.1 | NVIDIA T4 Tensor Core GPU: TRT 7.1, precision = INT8, batch size = 256 | V100: TRT 7.1, precision = FP16, batch size = 256 | A100 with 1 or 7 MIG instances of 1g.5gb: batch size = 94, precision = INT8。

A100 结合 MIG 技术可以更大限度地前进 GPU 加速的根底设备的运用率。凭仗 MIG,A100 GPU 可划分为多达 7 个独立实例,让多个用户都能运用 GPU 加速功用。凭仗 A100 40GB,每个 MIG 实例可分配多达 5GB,而随着 A100 80GB 显存容量的添加,此大小可翻倍至 10GB。

MIG 与 Kubernetes、容器和根据服务器虚拟化途径的服务器虚拟化合作运用。MIG 可让根底设备管理者为每项作业供应大小适宜的 GPU,一同保证服务质量 (QoS),然后扩展加速核算资源的影响规划,以掩盖每位用户

| N卡 N服务器到货计划 |

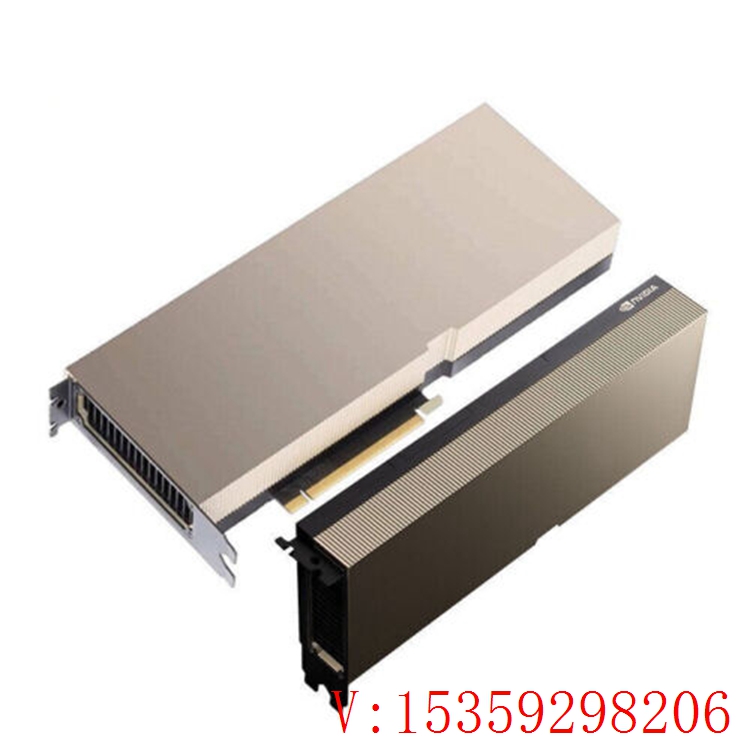

| A800 PCIE 单卡 |

| A800 NVLink 8卡模组 |

| A100 超微NV服务器 |

| A100 PCIE 单卡 |

| H800 超微NV服务器 |

| H100 PCIE 单卡 |

| H100 超微NV服务器 |

| GH200 超级服务器 |

客服1

客服1